🧹 Sweep이란?

0. Overview

단 1%라도 성능을 올리기위해 많은 사람들이 부단한 노력을 한다. (ex. paperswithcode)

결국, 모델의 성능을 최대로 끌어올리기 위해서는 Hyper-parameter를 변경하며 최적의 값을 찾기위해 이에 대해서도 부단히 노력을 기울여야 하지만, 이는 매우 피곤하고 Cost를 많이 들게 만든다.

이를 위해 등장한 것이 바로 W&B의 Sweep이다!

1. Sweep이란?

기본적으로 Hyper-parameter를 자동으로 최적화주는 Tool

Hyper-parameter Seach방식으로 다음 3가지가 존재한다.

- Grid 방식

- Random 방식

- Bayes 방식

선택한 search 방식으로 하이퍼 파라미터 튜닝이 완료 되면 WandB의 웹에서 제공되는 dashboard로 시각화된 모습을 볼 수 있다.

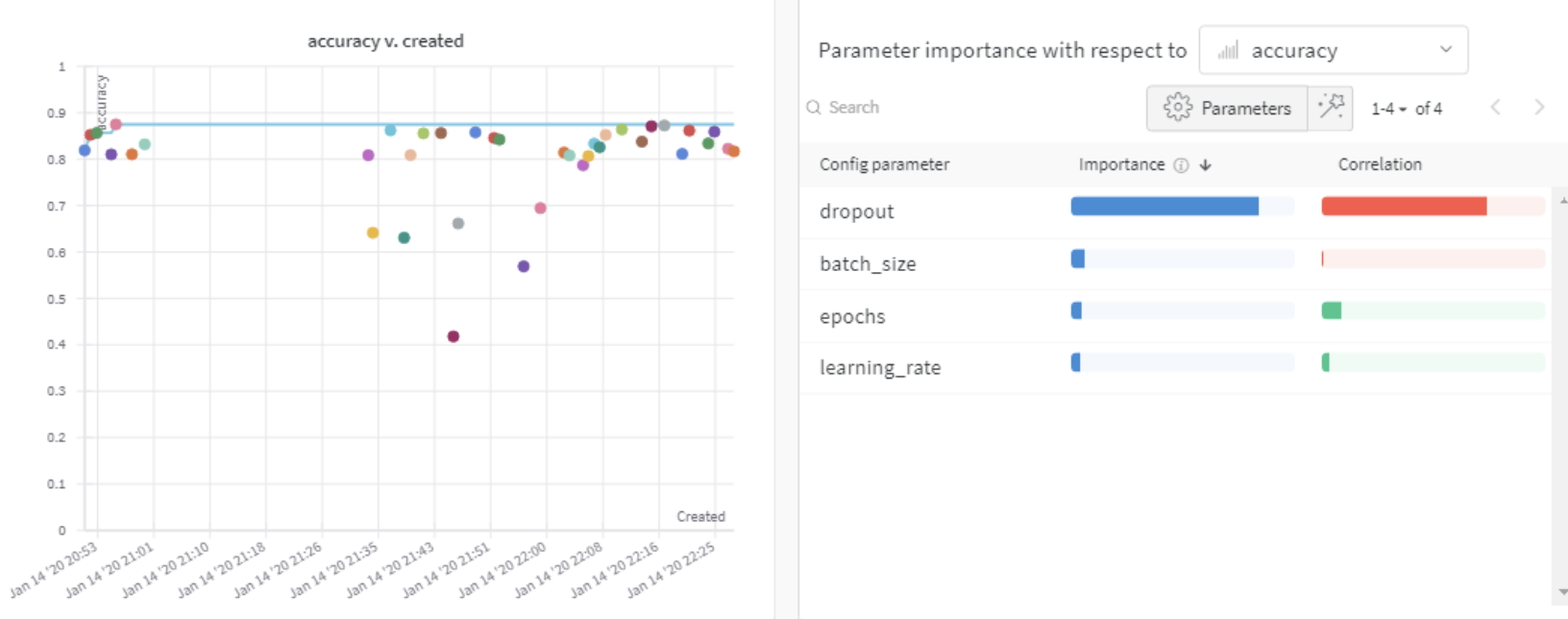

이렇게 시각화된 모습은 위의 그림과 같다. Sweep은 자동으로 tuning해주는 기능 뿐만 아니라,

각각의 hyper parameter들이 metric(accuracy, loss 등)에 얼마나 중요한 지 알려주고 상관관계를 보여주기에 필수적이라 할 수 있다.

(대시보드)

🧹 Sweep 사용법❗️

Tune Hyperparameters | Weights & Biases Documentation

Hyperparameter search and model optimization with W&B Sweeps

docs.wandb.ai

Sweep은 필히 2개의 단계(Initialize the Sweep, Run the Sweep Agent)가 필요하다.

1. Initialize the Sweep

∙ Sweep Configuration를 정의

Sweep Initialize를 위해 먼저 구성요소(configuration)를 정의해야한다.

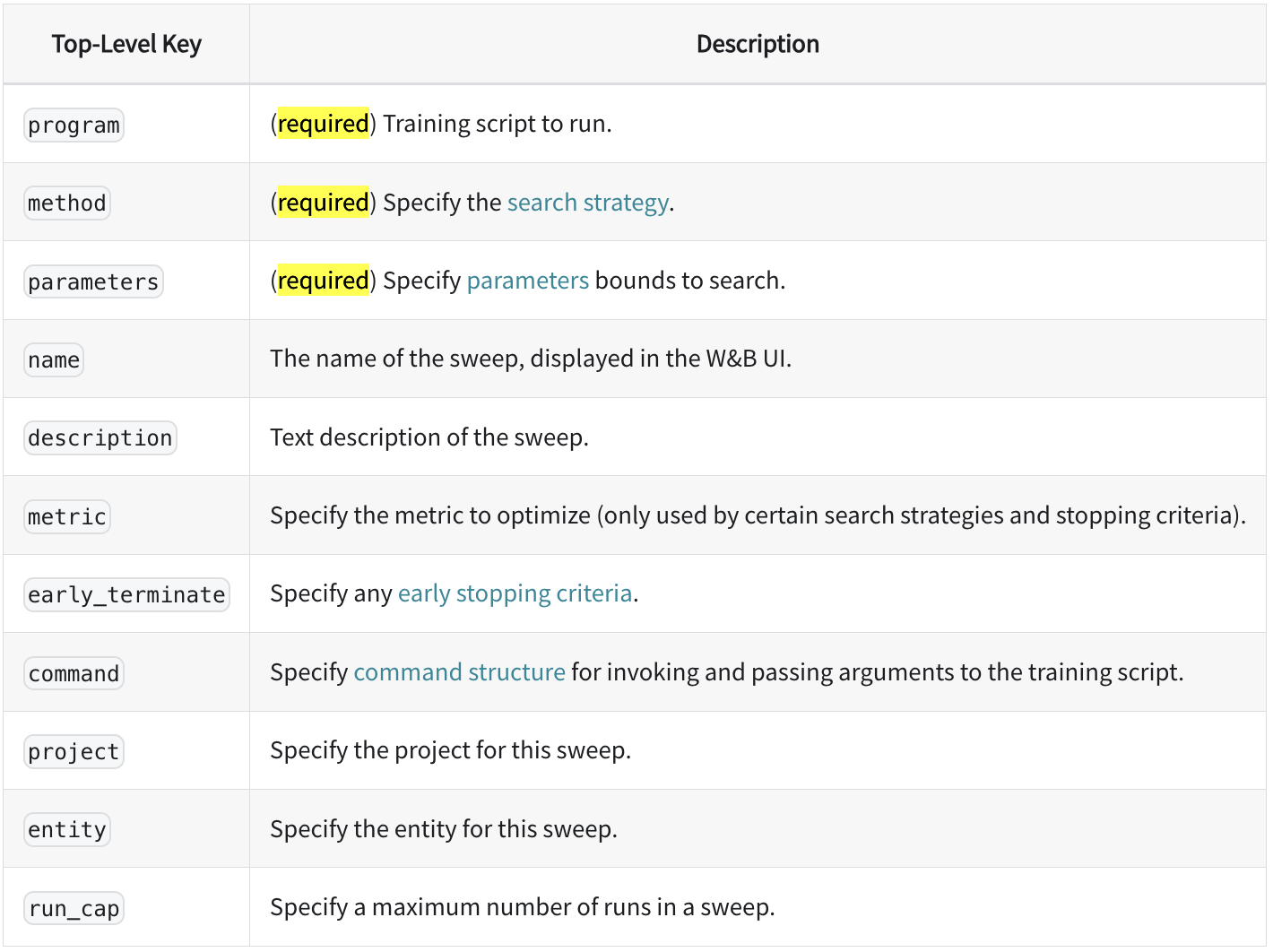

이를 위해 required와 option으로 나뉜다.

program(어디에서) method(무엇을) parameters(어떻게)

최적화를 할 것인지 정의해야한다.

이때, 최적화 방법으로 3가지가 존재한다.

- Grid 방식 : 가능한 모든 조합 탐색 (= Cost↑)

- Random 방식 : random하게 선택 (= Cost↓, opt찾을확률↓)

- Bayes 방식 : 이전에 시도한 hyper-parameter조합의 결과를 사용, 다음시도조합 추론시 사용

→ 모델성능을 최대로 향상시킬 수 있는 hyper-parameter조합을 찾는다. (= 초기탐색이 느림)

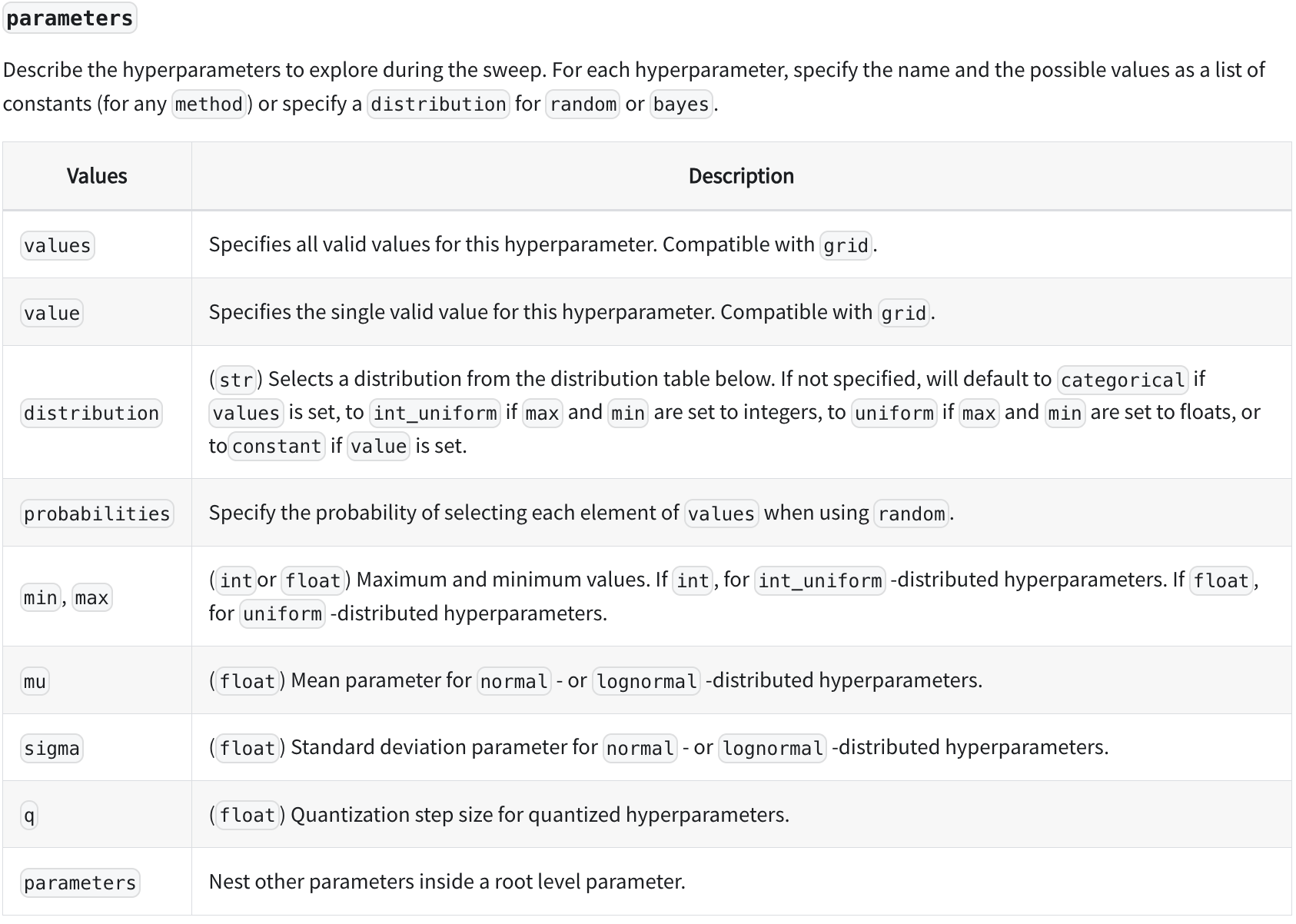

이때, 특히나 parameters 파트가 중요하기에 좀 더 살펴보자.

values value

Hyper-parameter에 대해 특정 값을 설정해서 우리가 원하는 값만 선택하게 해줌.

(value는 1가지 값을 설정해줄 때 사용)

distribution

values와 대조되는 방식.

특정 값을 설정하는 대신 원하는 분포 안에서 값을 선택.

Sweep에서는 uniform, normal, q_log_uniform과 같이 다양한 분포를 제공.

또한 선택된 분포를 min, max와 mu, sigma, q를 통해 자유롭게 변형가능.

min, max

분포의 최소∙최대값을 설정.

mu sigma

평균과 표준편차를 나타내는 값, 정규분포(normal)의 모양을 결정.

q

Quantization의 약자로 distribution에서 나온 값 X를 양자화.

ex) q를 2로 설정한다면 X는 2의 배수로 바뀜.

(ex. 식 round(X / q) *q를 적용하면, -2.96은 -2로 13.27은 14로 8.43은 8로 바뀜.)=

∙ project에 사용하기위해 Sweep API로 초기화

Sweep의 config가 제대로 정의가 됐다면 이제 프로젝트에 적용을 해줘야한다.

sweep 초기화 코드:

sweep_id = wandb.sweep(config.sweep_config)

위에서 정의된 config 변수를 입력으로 받고 sweep id를 출력해준다.

이 id는 다음 step에서 sweep을 실행시킬 때 고유한 identifier로 사용된다.

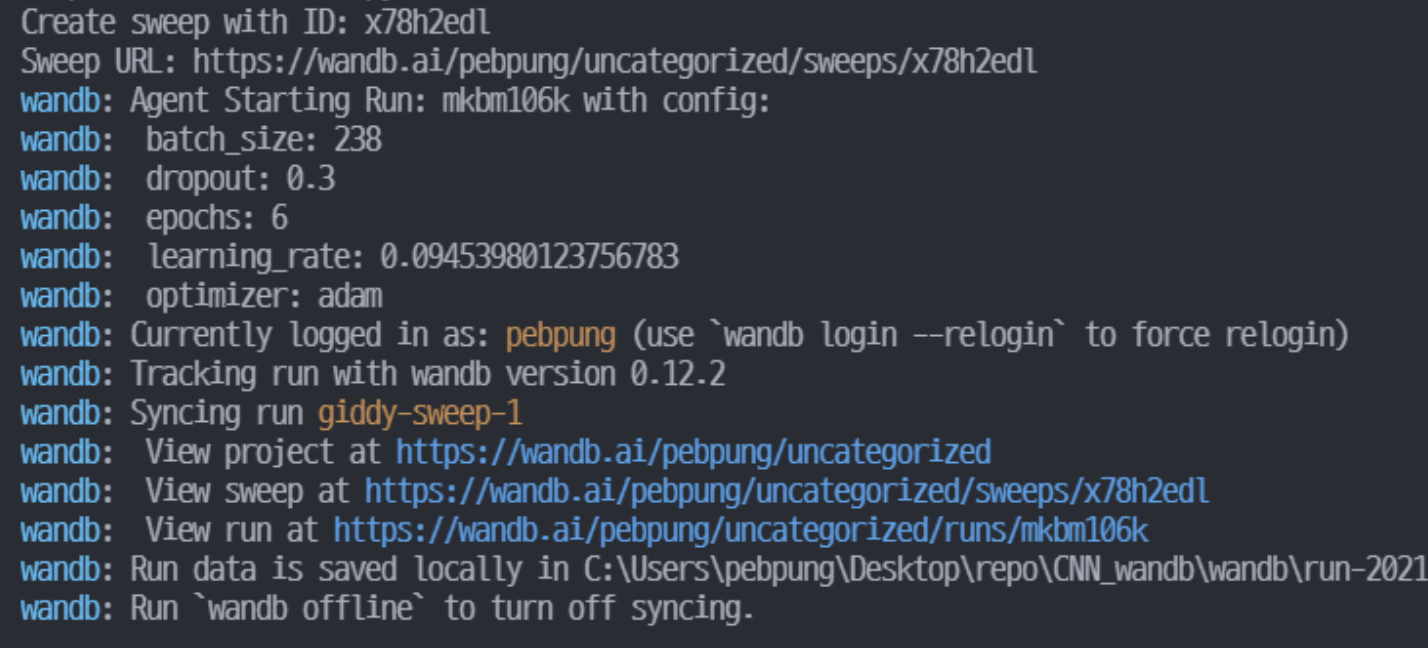

2. Run the Sweep Agent

- 함수나 프로그램을 W&B서버에서 실행.

이제 본격적인 실행만이 남았다.

위에서 정의해준 configuration을 사용해 sweep을 진행하자.

sweep 진행코드:

wandb.agent(sweep_id, function=train, count=count)이때, 위에서 출력된 sweep_id를 입력으로 넣어준다.

또한, function에 우리가 정의한 train함수를 넣어주고

sweep을 몇번 진행할 지 숫자를 count에 입력해준다.

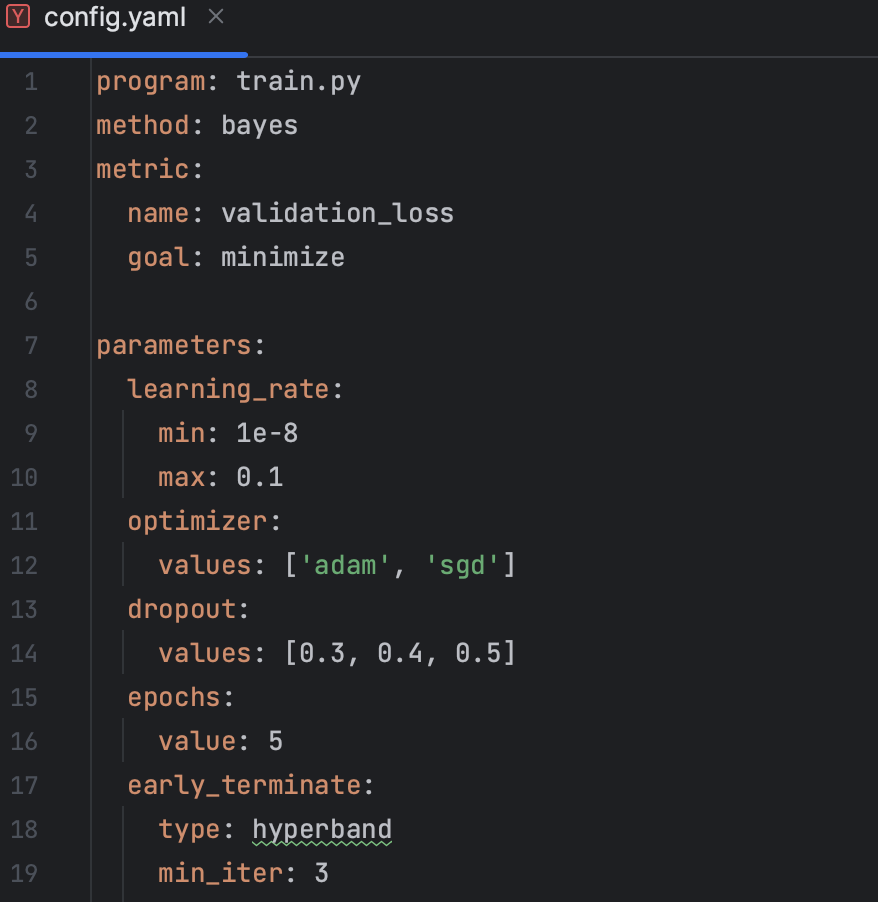

cf). yaml 파일로 실행하는 방법.

project와 entity를 기입 가능한 곳

- config 설정 하는 파일 (config.py 혹은 config.yaml)

- wandb.sweep()

- wandb.init()

- wandb.agent()

config를 .py파일로 정의하는 방식과 .yaml파일로 정의하는 방식이 존재.yaml파일로 실행하는 방법에 대해 알아보자.

1. config.yaml 파일 생성

2. . yaml 파일, Sweep에 입력

wandb sweep config.yaml

3. Sweep id를 Agent에 입력

wandb agent SWEEP_ID

cf) wandb terminal에서 명령어로 지정하기.

∙ sweep 횟수 제한

wandb agent --count [LIMIT_NUM] [SWEEPID]

∙ Multi-GPU sweep 사용

CUDA_VISIBLE_DEVICES=0 wandb agent sweep_id

CUDA_VISIBLE_DEVICES=1 wandb agent sweep_id

🧹 W&B Sweep 실행을 위한 예시코드

from dataset import SweepDataset

from model import ConvNet

from optimize import build_optimizer

from utils import train_epoch

import wandb

import config

parser = argparse.ArgumentParser()

parser.add_argument('--batch-size', type=int, default=8, metavar='N')

parser.add_arguemnt('--epochs', type=int, default=10)

args = parser.parse_args()

wandb.config.update(args)

def train():

wandb.init(config=config.hyperparameter_defaults)

w_config = wandb.config

loader = SweepDataset(w_config.batch_size, config.train_transform)

model = ConvNet(w_config.fc_layer_size, w_config.dropout).to(config.DEVICE)

optimizer = build_optimizer(model, w_config.optimizer, w_config.learning_rate)

wandb.watch(model, log='all')

for epoch in range(w_config.epochs):

avg_loss = train_epoch(model, loader, optimizer, wandb)

print(f"TRAIN: EPOCH {epoch + 1:04d} / {w_config.epochs:04d} | Epoch LOSS {avg_loss:.4f}")

wandb.log({'Epoch': epoch, "loss": avg_loss, "epoch": epoch})

sweep_id = wandb.sweep(config.sweep_config)

wandb.agent(sweep_id, train, count=2)sweep을 위한 config 파일은 config.py에 구현되어 있습니다. 코드를 순서대로 설명하면 다음과 같습니다.

1. hyper parameter의 초기값을 wandb.init에 입력으로 넣어줍니다.

2. w_config는 sweep을 할 대상 hyper parameter입니다.

3. loader, model, optimizer 함수에 w_config를 매개변수로 전달해줍니다.

4. model을 정의하면 wandb.watch 함수로 gradient를 추적합니다.

5. epoch 별로 나오는 log를 wandb.log에 저장합니다.

6. config 파일에 정의해둔 구성 요소를 wandb.sweep에 입력합니다.

7. wandb.sweep에서 나온 id와 위에 구현된 train 함수, 그리고 횟수를 wandb.agent에 입력하고 sweep을 실행시킵니다.

참고) https://pebpung.github.io/wandb/2021/10/10/WandB-2.html

🧹 Sweep 시각화

WandB실행 이후, 시각화된 결과를 분석해보자. (대시보드)

이를 위해서는 Sweep workspace의 구성방식에 대해 알아봐야한다.

좌측 그래프: y축은 metric, X축은 생성된 날짜를 의미.

우측 표: hyper parameter가 metric(accuracy, loss 등)에 얼마나 중요한 지와 상관관계가 어느정도 인지도 알려줌.

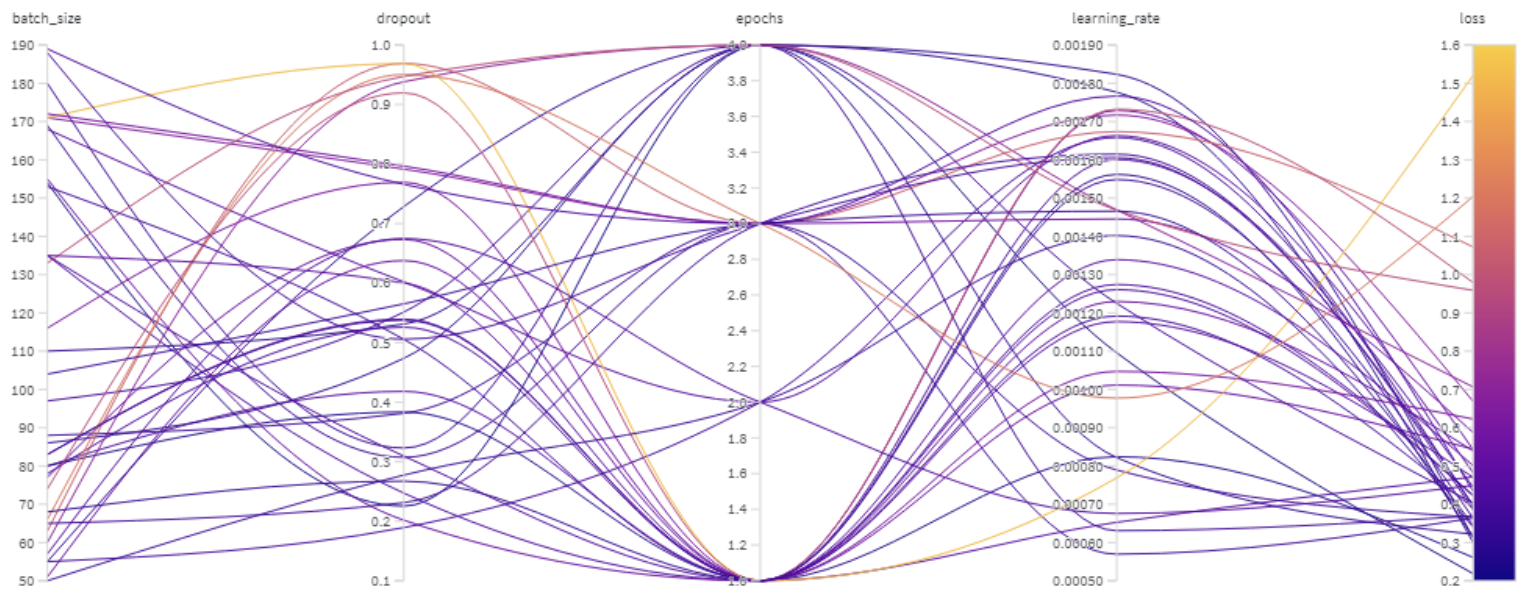

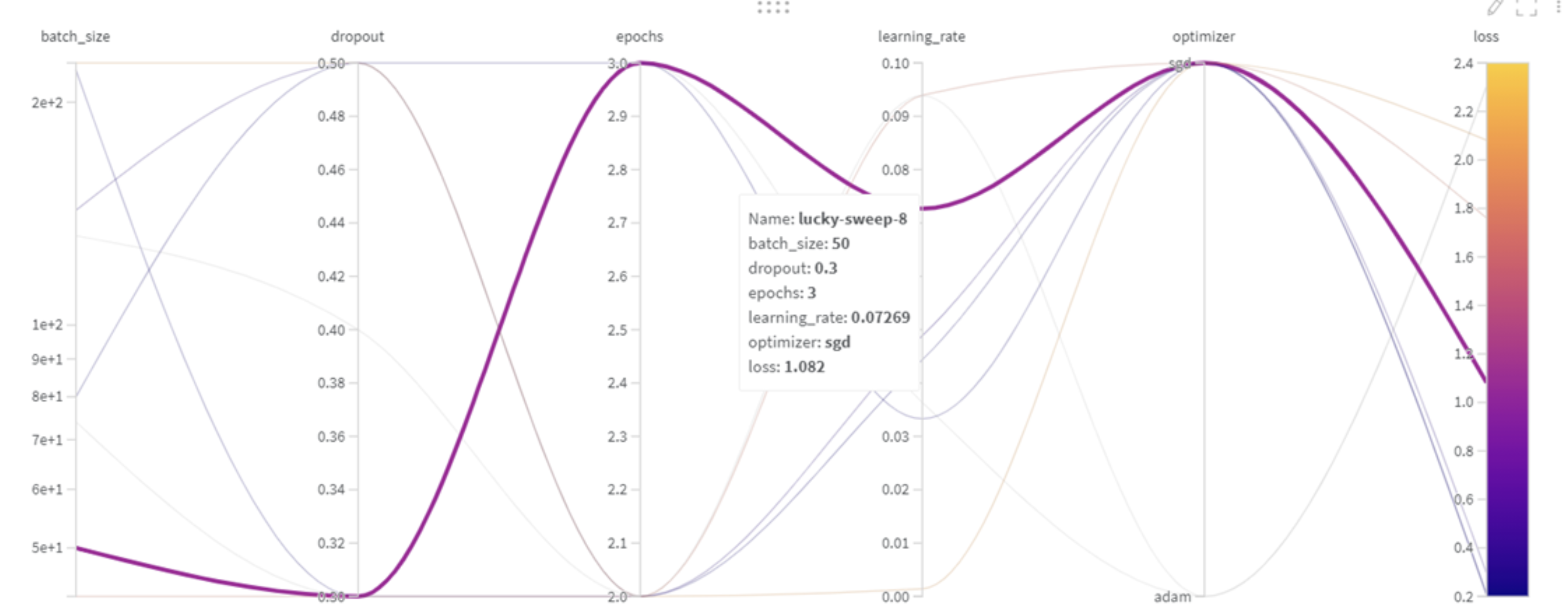

위 그림은 hyper-parameter선택과정을 시각적으로 보여준 그림이다.

∙ X축: config에서 설정한 hyper-parameter의 종류

∙ y축: config에서 설정한 hyper-parameter의 범위

추가적으로 마우스를 가져다 놓으면 해당 그래프에서의 값을 알 수 있다.

'Deep Learning : Vision System > Pytorch & MLOps' 카테고리의 다른 글

| [🔥PyTorch 2.2]: transformv2 , torch.compile (0) | 2024.01.31 |

|---|---|

| [WandB] Step 3. WandB 시각화 방법. (0) | 2024.01.09 |

| [WandB] Step 1. WandB Experiments. with MNIST (2) | 2024.01.09 |