※ Computer Vision

• Computer Vision -> 자연어 처리 -> 오디오 부분 순으로 발전하였기에 가장 발전된 분야

• 시각적 세계를 해석하고 이해하도록 컴퓨터에 학습시키는 인공지능 분야로 컴퓨터를 이용한 정보처리를 진행한다.

• 따라서 컴퓨터 비전은 정보를 데이터로 표현하기 매우 적절한 구조를 갖고 있다.

cf. 만약 It's late를 데이터로 표현하려면...? (feat. 자연어 처리)

자연어의 경우, 자연어는 데이터로 표현하기 어려운데, (데이터를 많이 갖고 있기 때문)

예시에서 It's의 t와 late의 t가 똑같은 용도로 사용될까? 이런 저런 이유로 컴퓨터비전은 데이터를 표현하기 매우 좋다.

※ PASCAL VOC challenge 문제

초창기 이미지 dataset에 대해 인식성능을 겨루는 대회가 열렸고,

가장 대표적인 PASCAL VOC(Visual Object Classes) Challenge 로 이 대회를 기점으로 이미지 인식에서 다루는 문제들이 아래와 같이 정형화 되었다,

• Classification

• Detection

• Segmentation

Classification

※ Classification

특정 class에 해당하는 사물이 포함되어 있는지 여부를 분류하는 모델

classification은 Detection, Segmentation문제를 향한 출발점이기에 더더욱 중요하며 다음 2가지로 나눌 수 있다.

§ 단일 사물 분류 문제

- 모든 이미지가 반드시 하나의 사물만 존재

- 전체 class에 대한 confidence score S를 비교, 가장 큰 confidence score를 지니는 class로 선정하는 방법

§ 복수 사물 분류 문제

- 이미지 상에 여러개의 사물들이 포함되어 있음

- 단순히 가장 큰 confidence score를 갖는 class 하나만을 선정하는 방법은 합리적이지 않게 된다.

- 방식이 조금씩은 다르나 class별 threshold를 정해놓고 S > threshold 일 때

==> "주어진 이미지 안에 해당 class가 포함되어 있을 것이다" 라고 결론지음

▶ 평가척도

• accuracy = 올바르게 분류한 이미지 수 / 전체 이미지 수

- accuracy는 classification문제에서 일반적으로 test를 위해 측정한다.

- 이 방법은 단일 사물 분류문제에서는 즉각사용해도 별 문제가 없다.

- 하지만 복수 사물 분류문제에서는 곤란해질 수 있어서 아래와 같은 평가척도를 사용한다.

• precision과 recall 은 class A에 대해 다음과 같이 측정한다.

precision = 올바르게 분류한 A 이미지 수 / A로 예측한 이미지 수

recall = 올바르게 분류한 A 이미지 수 / 전체 A 이미지 수

Detection

※ Detection

image localization이라고도 불리며 classification에서 어느 위치에 포함되어 있는지 "박스형태"로 검출하는 모델을 만드는 것이 목표이다. 이 박스를 bounding box라 한다.

▶ 평가척도 IOU (Intersection Over Union)

• 사물의 Class와 위치의 예측결과를 동시에 평가해야해서 사물의 실제 위치를 나타내는 실제 bounding box (GT bounding box)정보와 예측 bounding box가 얼마나 "겹쳐지는지"를 평가한다.

Bp: 예측 bounding box

Bgt: GT bounding box

Bp와 Bgt의 IOU = Bp∩Bgt 영역넓이 / Bp∪Bgt 영역넓이

보통 이에 대한 threshold를 0.5로 정해놓고 있으며 여러개의 bounding box가 모두 IOU를 50%를 넘겨 매칭되면

결과적으로 매칭에 실패한것으로 간주한다. (즉, 복수 개의 매칭이 되면 안된다.)

Segmentation

※ Segmentation

어느 위치에 있는지를 "Pixel 단위로 분할"하는 것으로 Detection보다 더 자세하게 위치를 표시한다.

이미지 내 각 위치상의 Pixel들을 하나씩 조사, 조사대상 Pixel이 어느 Class에도 해당하지 않으면?

=> background Class로 규정하여 해당 위치에 0을 표기하고 이 결과물을 mask라 부른다.

§ Semantic Segmentation

- 분할의 기본단위: Class

- 동일한 Class에 해당하는 사물은 동일한 색상으로 예측하여 표시

§ Instance Segmentation

- 분할의 기본단위: 사물

- 동일한 Class에 해당하더라도 서로 다른 사물이면 다른 색상으로 예측하여 표시

▶ 평가척도 IOU (Intersection Over Union)

Ap: 예측 mask의 특정 Class 영역

Agt: GT(실제) mask의 해당 Class 영역

Ap와 Agt의 IOU = Ap∩Agt 영역넓이 / Ap∪Agt 영역넓이

※ Pixel (픽셀)이란?

• 픽셀을 이용해 정보를 표현하기에, 픽셀은 한 단위(unit)로 "인간이 정의한 것"이다.

• 또한 pixel = brightness (밝기)를 이용해 표현하는데 이를 통해 알 수 있는 중요한 사실이 있다.

즉, 픽셀은 이미지의 최소단위이다! (픽셀이 나타내는 값 = 밝기.)

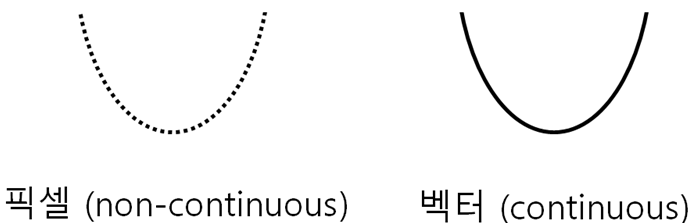

픽셀 함수에서 표현되는 데이터의 느낌과 정 반대가 있다.

↔ vector(수학적 의미가 아닌, vision information 측면의 벡터), 벡터는 함수같은 형식

픽셀: noncontinuous (어떤 unit을 정해 vector의 특정 부분을 묶은 것)

벡터: continuous한 것

실제 존재하는 사물들은 vector자체로 저장하기는 너무 방대하고 연속적이기에

이를 grid로 모두 잘라 pixel로 하여 특정범위별로 밝기를 0.1, 0.9처럼 하여 그 값들을 data로 3, 23처럼 저장하는 것

이렇듯 pixel은 숫자여서 우리가 보고 있는 모든 것들을 숫자로 표현가능하기에 컴퓨터 비전이 발전할 수 있었다.

※ Pixel과 RGB

pixel은 숫자로 이루어져 있는데 그 크기가 1 Byte이다. (0~255의 숫자)

R(1 Byte) G(1 Byte) B(1 Byte) 이렇게 (1Byte)^3으로 총 1600만가지 색을 표현할 수 있다.

A(1 Byte): Alpha, 즉 투명도까지 이용한다면?

결과적으로 image는 4 Byte로 표현이 가능하며 이것이 바로 1 Pixel 이다.

[실습]

<import 부분>

import numpy as np

import cv2 # camera, image 등 conputer vision을 쓰기 위한 openCV

import numpy as np # 빠른 계산을 위한 라이브러리

import matplotlib.pyplot as plt # visualization을 위한 matplotlibcap = cv2.VideoCapture(1) # cap이라면 변수에 카메라 기능을 가져옴 0번이 전면 카메라ret,frame = cap.read() #ret은 성공, 실패, frame은 image frame

print(frame)

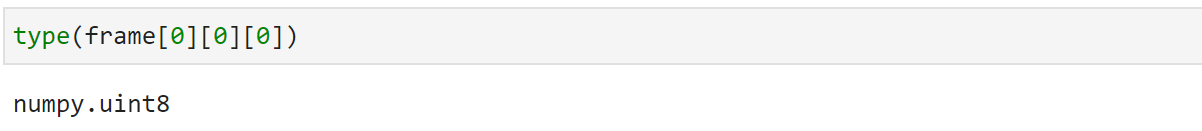

아래 사진처럼 frame[0][0][0]에 해당하는 숫자인 121이 uint8 즉, unsigned int 8bit값인 것을 알 수 있다.

따라서 정리하자면 frame이라는 변수는 uint 8bit의 집합 data로 이루어져있음을 알 수 있다.

( image type의 default 값은 uint8이다)

찍은 사진에 대해 출력을 해보자.

여기서 잠깐!

실습을 하던 중 앞에서 배운 내용을 상기시켜보자.

image = 숫자라는 것이 중요하다 하였다.

Q. 그렇다면, 픽셀은 밝기를 대변하니까 frame x 2를 하면?

A. 밝기가 밝아진다!

다만, 기존의 255크기를 넘어설 수 있으며 (ex 150 * 2 = 300) 이때 overflow가 발생하기에

아래와 같은 방식을 사용한다.

※ Contrast와 Gamma

contrast: 대비, 밝은것을 더 밝게, 어두운것을 더 밝게! 2(frame-127)+127 (x절편 이하값은 손실 발생)

따라서 손실발생을 거의 없애주기 위해서 sigmoid 함수사용!

[과제]. sigmoid함수를 사용한 contrast해보기!

Gamma (사진변수 / 255)^(감마) x 255

감마가 높으면 변화량이 커지고 감마가 낮아지면 변화량이 낮아지는데, 선형 contrast보다 손실발생율이 거의 없어서 훨씬 사용에 유리하다.

cf. astype을 통해 형변환이 가능하다!

plt.imshow(frame에 대한 연산.astype(np.int32))

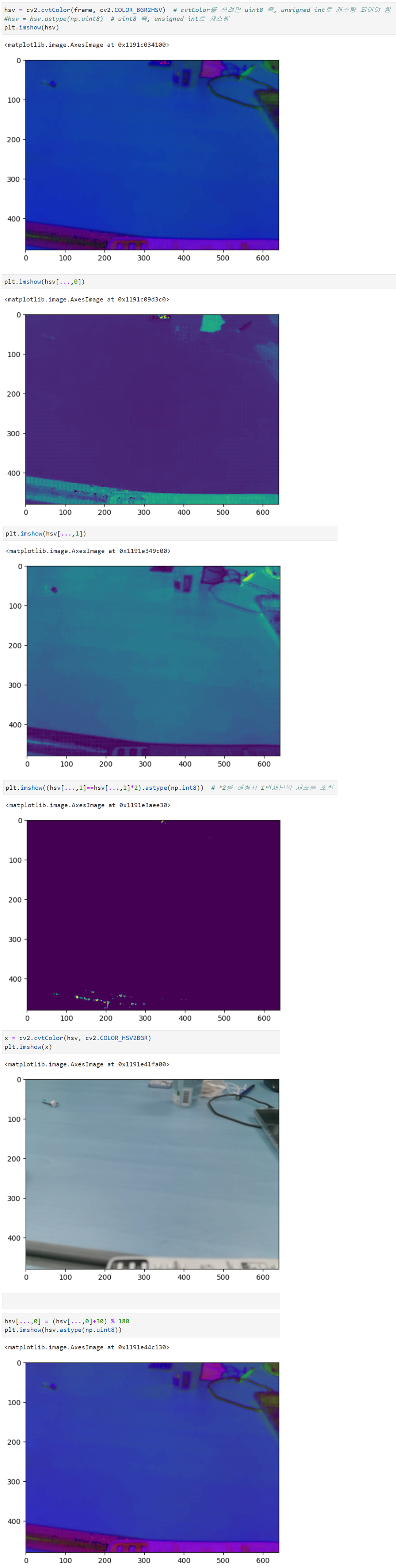

※ RGB와 HSV

RGB말고도 사용할 수 있는 색 공간이 있을까?

RGB의 color space: 정육면체형

HSV의 color space: 원뿔형이고, uint를 사용한다.

- Hue: 0~179사이로 표현 ( pi값으로 value값 1당 2도를 의미 )

모든 pixel이 색이 조금씩 바뀜 (각도의 이동) / hsv[..., 0] , 0번 채널 즉, hue에 접근하는 것.

- Saturation: 채도, 색의 농도, 클수록 진하다 / plt.hsv[... , 1] ,1이라는 것은 1번 채널만 본다는 뜻이다.

- Value: 명도, 색의 밝기를 의미

[실습]

[과제 해보기]

'Deep Learning : Vision System > 영상처리 ~ 최신비전' 카테고리의 다른 글

| [Vision System]. Transformation (rotation, scale, transition) (0) | 2023.01.22 |

|---|---|

| [Vision System]. Scaling & Rotation (0) | 2022.12.29 |

| [Vision System]. Interpolation(with vectorization) (0) | 2022.11.30 |

| [Vision System]. image blending & image masking (0) | 2022.11.23 |

| [Vision System]. image crop & padding, translation, axis (0) | 2022.11.17 |